آیا مدلهای هوش مصنوعی واقعاً «فکر میکنند»؟ این پرسشی مهم است، چون وقتی با ابزارهایی مثل ChatGPT یا Claude کار میکنیم، بهنظر میرسد که ربات در حال فکر کردن است. حتی پیامهایی ظاهر میشوند که میگویند «در حال فکر کردن…» و این روزها میتوانیم زنجیره تفکر (Chain of Thought) ربات را هم بخوانیم تا ببینیم چطور به نتیجه رسیده است.

اما واقعیت این است که اگرچه مدلهای زبانی بزرگ (LLMها) و دیگر سیستمهای هوش مصنوعی برخی جنبههای تفکر را تقلید میکنند، هنوز با چیزی که مغز انسان انجام میدهد تفاوت زیادی دارند. با این حال، پژوهشهای جدید درباره «ماشینهای تفکر پیوسته» (Continuous Thought Machines یا CTMها) ممکن است این وضعیت را تغییر دهند.

ماشین تفکر پیوسته چیست؟

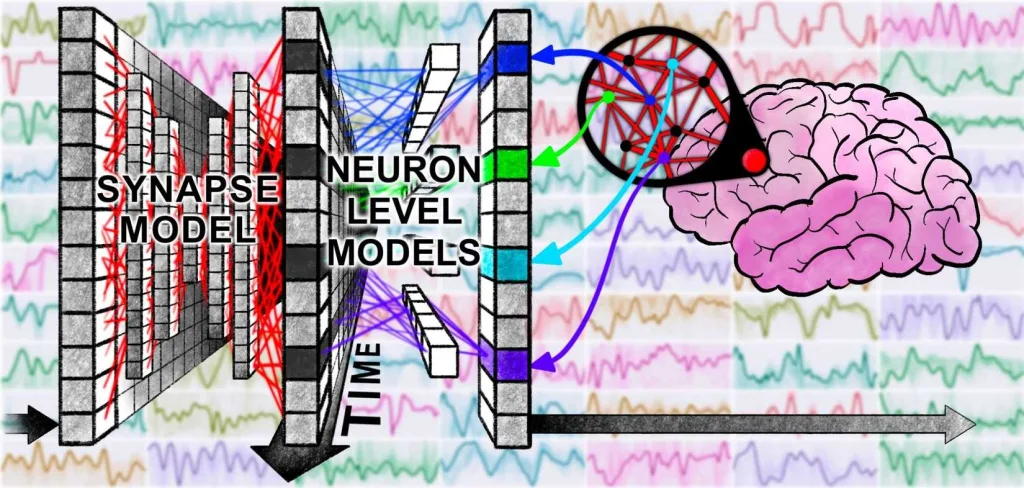

ماشین تفکر پیوسته (CTM) نوعی جدید از شبکه عصبی است که عنصر زمان را وارد فرآیند تفکر میکند. برخلاف محاسبات لحظهای و تکمرحلهای که در مدلهای معمولی وجود دارد، در CTM هر نورون، فعالیت گذشته خود را به خاطر میسپارد و از آن تاریخچه برای تصمیمگیری درباره گام بعدی استفاده میکند. در ماه مه ۲۰۲۵، شرکت Sakana AI مدل CTM را در یک مقاله پژوهشی و یک پست وبلاگی بهطور مفصل معرفی کرد.

شرکت Sakana ادعا میکند که CTM نوعی جدید از شبکه عصبی مصنوعی است که شباهت بیشتری به نحوه عملکرد مغزهای طبیعی دارد. در CTM، نورونها فقط یکبار فعال نمیشوند و تمام؛ بلکه دارای نوعی «حافظه کوتاهمدت» هستند و میتوانند الگوهای شلیک خود را با نورونهای دیگر هماهنگ کنند. وضعیت داخلی شبکه با الگوهای هماهنگی زمانی بین نورونها تعریف میشود.

این موضوع یادآور همزمانی نورونی در مغزهای زیستی است که منجر به ایجاد امواج مغزی میشود. این موضوع باعث میشود CTMها تفاوت اساسی با شبکههای عصبی عمیق استاندارد یا مدلهای ترنسفورمر داشته باشند. به عنوان مثال، یک مدل ترنسفورمر معمولی (مثل مدلهای زبانی امروزی) یک متن یا تصویر را در تعداد ثابتی از لایهها و در یک «انفجار کوتاه پردازشی» تحلیل میکند و بعد از آن، بهاصطلاح «خاموش» میشود تا ورودی بعدی از کاربر برسد.

نتایج چشمگیر (حداقل روی کاغذ)

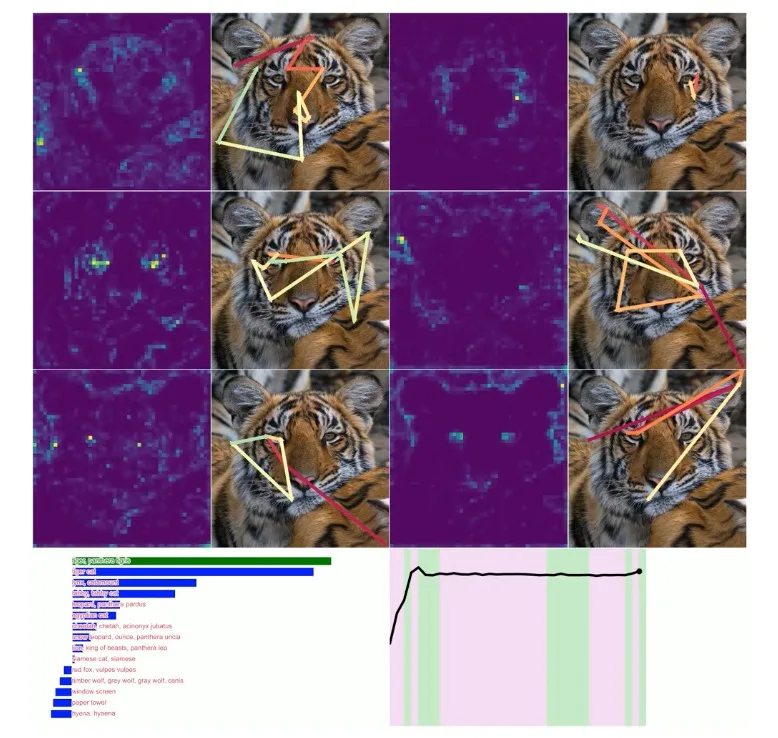

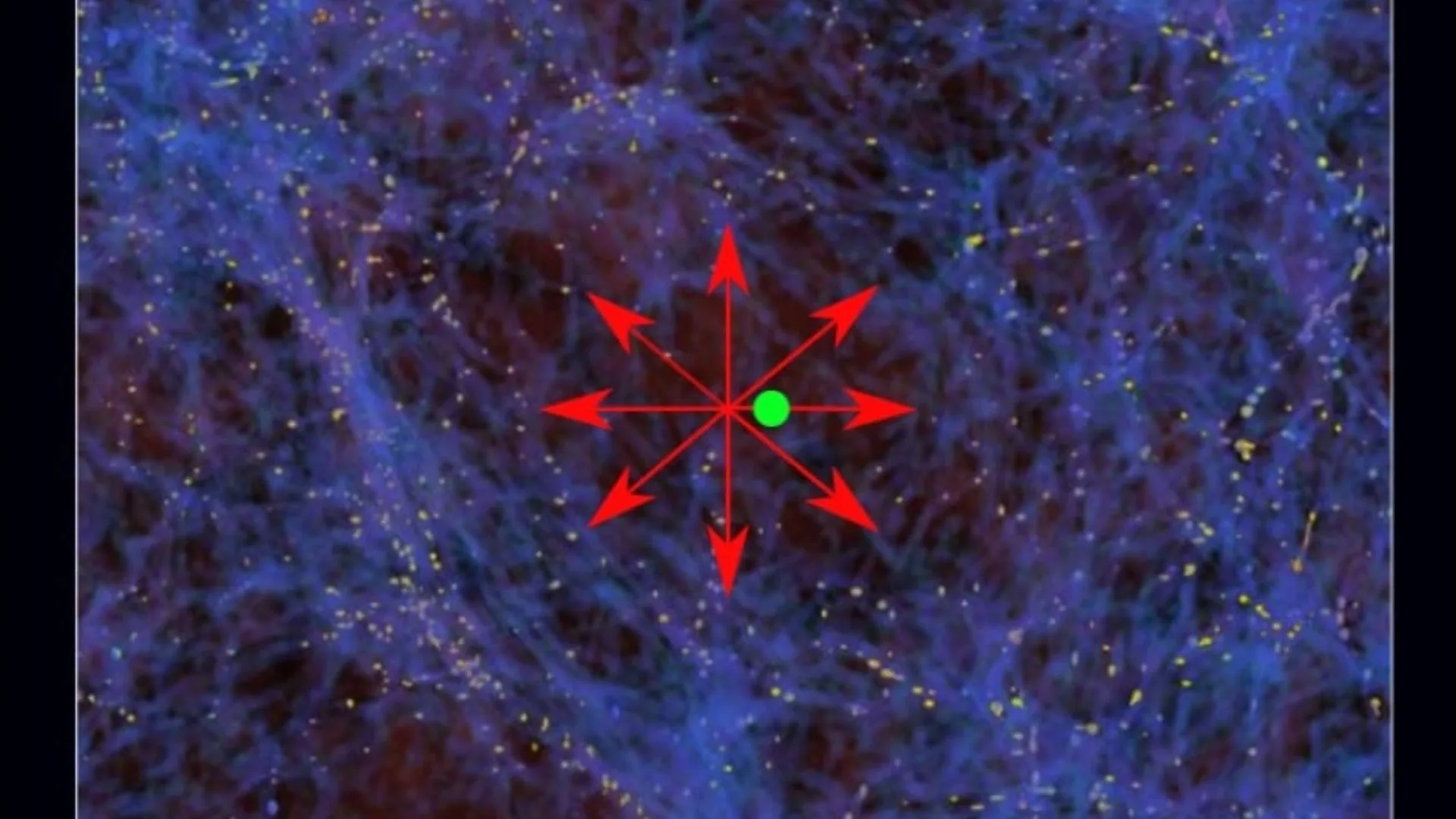

تأثیرات این ایده میتواند بسیار عمیق باشد—اگر واقعاً درست عمل کند. در پست وبلاگ Sakana، مثالی از حل کردن ماز (maze) و نگاه کردن به تصاویر واقعی آورده شده که واقعاً جالب است:

«شگفتانگیز است که با وجود آنکه مدل به طور مشخص برای حل ماز طراحی نشده، راهحل نهایی بسیار قابل تفسیر و شبیه تفکر انسانی است؛ طوری که میتوانیم ببینیم چطور مسیر را گامبهگام دنبال میکند، انگار در حال “فکر کردن” است. درباره تصاویر واقعی هم، هیچ مشوق مشخصی برای نگاه کردن به اطراف وجود ندارد، اما مدل بهطور شهودی این کار را میکند.»

در ادامه، این توضیح را نیز اضافه میکنند:

«ما این مدل را “ماشین تفکر پیوسته” (CTM) نامیدهایم، مدلی که میتواند از بُعد جدید زمان، دینامیکهای پیچیده نورونها و اطلاعات همزمانی استفاده کند تا درباره یک وظیفه “فکر” کند و پیش از پاسخ دادن، برای آن برنامهریزی انجام دهد. واژه “پیوسته” به این دلیل است که مدل کاملاً در یک بُعد داخلی تفکر فعالیت میکند. این مدل نسبت به دادههایی که دریافت میکند غیرهمزمان است؛ یعنی میتواند به یک شکل واحد هم روی دادههای ایستا (مثل تصویر) و هم روی دادههای دنبالهدار (مثل متن) تفکر و استدلال کند. ما آن را روی طیف وسیعی از وظایف آزمایش کردیم و متوجه شدیم که در حل مسائل متنوع، بسیار قابل تفسیر عمل میکند.»

اگرچه نباید زودتر از موعد برای این مدل هیجانزده شد—تا وقتی که آزمایشهای مستقل بیشتری روی آن انجام شود—اما برخی از نشانهها کمکم وارد قلمرو شکلگیری مقدماتی نوعی آگاهی ابتدایی میشوند.

چرا CTM بهتر از شبکههای عصبی فعلی است؟

تمام ایده پشت CTM حذف مفهوم «حل یکباره» مسائل است—چیزی که تاکنون یکی از معیارهای استاندارد در مدلهای هوش مصنوعی بوده. در حالت معمول، یک مدل باید در همان پنجره پردازشی محدود و یکمرحلهای خود، پاسخ درست را بدهد. بهعنوان مثال، مدلهایی مانند ChatGPT که با ترنسفورمر کار میکنند، دقیقاً بر این مبنا طراحی شدهاند.

در مقابل، CTM طوری طراحی شده که بتواند با گذر زمان فکر کند، تصمیم بگیرد، به عقب برگردد و مجدداً مسیرش را تنظیم کند—ویژگیهایی که بیشتر به فرآیند تفکر انسانی شباهت دارند.

یکی از دلایلی که مدلهای زبانی بزرگ (LLMها) هنوز راه مؤثری برای اصلاح درصد کوچکی از اشتباهات خود ندارند همین مسئله است. روشهایی مانند زنجیره تفکر (Chain-of-Thought)، خودپیشنهادی (Self-Prompting) و حتی چرخاندن پرسش بین دو مدل مختلف برای بهبود پاسخ پیشرفتهایی محسوب میشوند، اما به نظر میرسد رویکرد CTM میتواند شکاف مهمی در زمینه دقت و قابلیت اطمینان پر کند.

بر اساس آنچه Sakana AI در مقالات خود بیان کرده، این فناوری میتواند به ترکیبی از قدرت محاسباتی LLMها و قابلیت سازگاری و رشد مغزهای زیستی منجر شود. این موضوع حتی میتواند تأثیر قابلتوجهی بر حوزه رباتیک داشته باشد؛ بهطوریکه ماشینهای فیزیکی بتوانند یاد بگیرند، رشد کنند و در دنیای واقعی به شکلی شبیه انسانها عمل کنند.

قدرت تفکر پیوسته؛ اما با بهای خاص خود

هرچند تفکر مداوم قدرت بالایی دارد، اما بیهزینه هم نیست. CTMها بسیار پیچیدهتر و منابعبر از شبکههای عصبی معمولی هستند. از آنجا که هر نورون باید تاریخچه فعالیتهایش را حفظ کند، وضعیت داخلی مدل بهطرز قابل توجهی گستردهتر میشود. نتیجه این است که:

- آموزش این مدلها به قدرت پردازشی بالا و حافظه بیشتر نیاز دارد.

- فرایند یادگیری ممکن است زمانبرتر باشد و به دادههای بیشتر برای همگرایی نیاز داشته باشد.

- در زمان استفاده (Inference)، اگر مدل تصمیم بگیرد که چند مرحله فکر کند، پاسخگویی میتواند کندتر شود.

افزون بر این، اکثر ابزارها و کتابخانههای فعلی بر اساس مدلهای ایستا و غیرپیوسته طراحی شدهاند، نه CTMها. پس اگر این رویکرد واقعاً مؤثر باشد، باید منتظر تغییرات اساسی در ابزارهای نرمافزاری باشیم.

کی باید تفکر را متوقف کرد؟

یک مشکل بزرگ دیگر این است که چه زمانی مدل باید “تفکر” را تمام کند؟ خطر «تفکر بیپایان» وجود دارد، یعنی CTM ممکن است در یک حلقه بیپایان گرفتار شود. بنابراین نیاز به مکانیزمهای کنترلی پیشرفته است تا مدل بداند چه زمانی باید خروجی بدهد. در غیر این صورت، خطر تقویت خطا و حتی توهمزایی (hallucination) همانند مدلهای فعلی وجود دارد، زیرا ممکن است مدل از حقیقت اولیه دور شود.

و نهایتاً، یک چالش مهم دیگر این است که CTMها هنوز از نظر دقت، به سطح مدلهای ترنسفورمر پیشرفته نرسیدهاند. طبق گزارشی از VentureBeat، CTM در آزمونهای سنجش دقت، فعلاً ضعیفتر از مدلهای برتر موجود عمل کرده است.

ذهن انسان: هنوز یک راز پیچیده

با اینکه CTMها از نظر عملکرد شباهتهایی به مغز انسان دارند، اما واقعیت این است که ما هنوز درک کاملی از ذهن خودمان هم نداریم. ممکن است محققان هوش مصنوعی بهطور تصادفی به راهحلی شبیه چیزی که طبیعت از طریق انتخاب طبیعی ساخته، دست یافته باشند. یا شاید هم مسیری کاملاً موازی خلق کردهایم که روزی به همان سطح توانایی برسد.

مدتهاست که این حس وجود دارد که مدلهای زبانی بزرگ مثل LLMها تنها بخشی از پازل هوش عمومی هستند—مثلاً بیشتر شبیه به مرکز زبان در مغز عمل میکنند، نه خود مغز کامل. در نگاه اول، CTMها برای من مثل قطعه دیگری از این پازل بزرگتر بهنظر میرسند. به همین دلیل، روند پیشرفت Sakana AI را با علاقه زیادی دنبال خواهم کرد.

دیدگاه ها